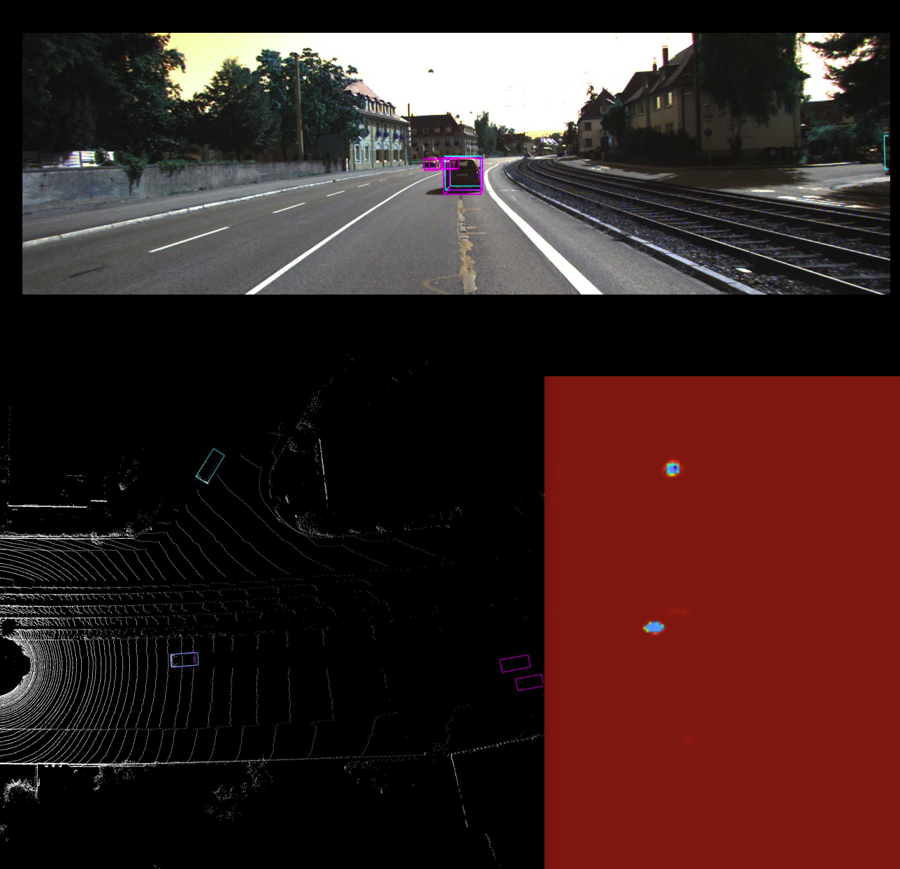

VoxelNet (50%)

1. 개요

2. 설치 (Docker 기반)

데이터 준비

└── DATA_DIR

├── training <-- training data

| ├── image_2

| ├── label_2

| └── velodyne

└── validation <--- evaluation data

| ├── image_2

| ├── label_2

| └── velodyne도커 pull & 실행

$ docker pull adioshun/voxelnet

$ docker run --runtime=nvidia -it --privileged --network=host -v /tmp/.X11-unix:/tmp/.X11-unix --volume="$HOME/.Xauthority:/root/.Xauthority:rw" -e DISPLAY -v /media/{DATA_DIR}/datasets:/dataset --name 'voxelnet' adioshun/voxelnet /bin/bash3. 실행

설정 수정(In the docker )

train

Evaluate

결과 확인

Last updated

Was this helpful?